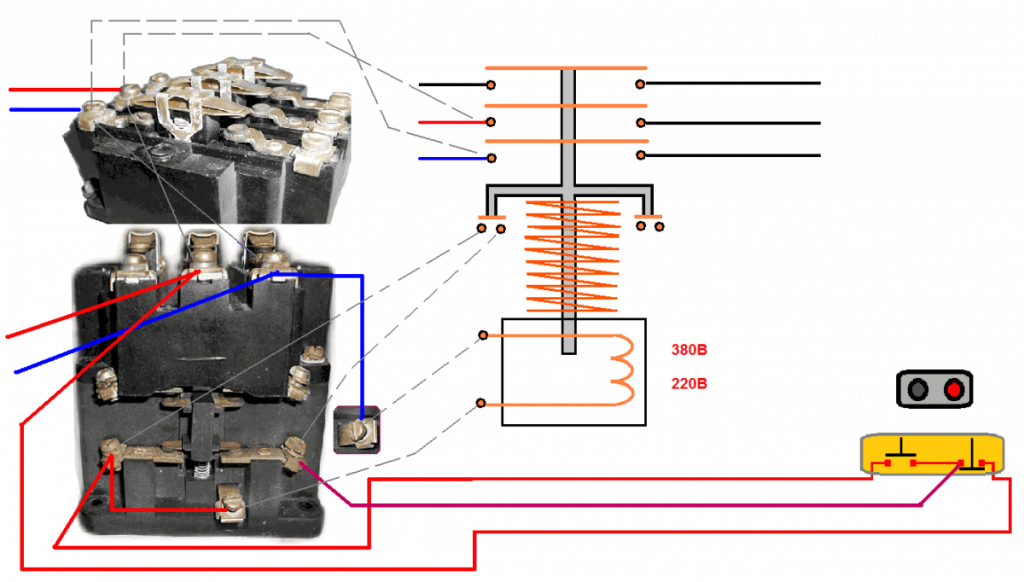

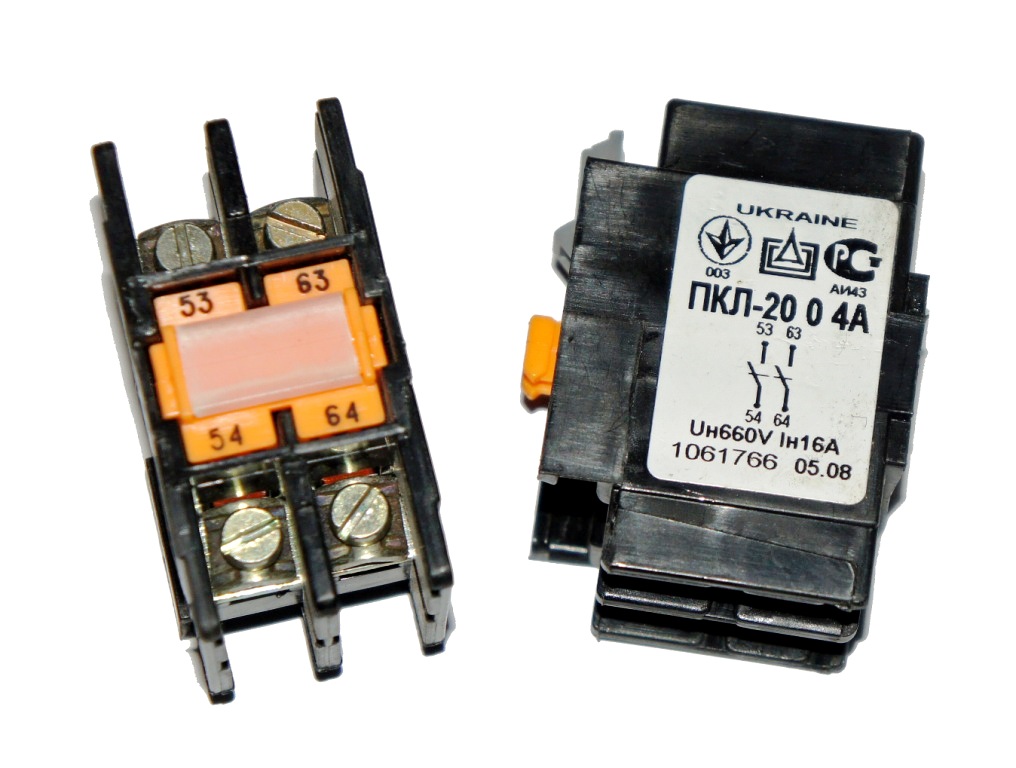

Для увеличения количества вспомогательных контактов используется приставка контактная ПКЛ. На промежуточные реле и пускатели легко устанавливаются приставки с разным набором замыкающих, размыкающих контактов. Изделие механически соединяется с пускателями в области входных зажимов, после чего фиксируется над траверсой оборудования. Входные зажимы расположены сверху. Контактные приставки монтируются простым движением снизу вверх по специальным направляющим. Выступ на держателе контактов совмещается с пазом на контактодержателе пускателя. Практичный способ крепления обеспечивает надежную, жесткую связь между пускателем и приставкой. Изделия, изготавливаемые с различным уровнем защиты, имеют разную коммутационную износостойкость. ПКЛ при необходимости позволяет увеличивать количество дополнительных контактов. Окончательная фиксация осуществляется посредством защелки. Приставки ПВЛ изготавливаются в двух вариантах исполнения: для срабатывания при включении оборудования (контакты переключаются через определенное время после включения) и для срабатывания при отключении пускателя. Изделия выпускаются в нескольких вариантах исполнения по времени срабатывания. Все они отличаются плавностью регулировки, прочностью конструкции. По принципу функционирования ПКЛ и ПВЛ относятся к пневматическим реле. Они могут использоваться в качестве комплектующих стационарных установок, в схемах управления электроприводами постоянного, переменного тока. Отдельные виды контактных приставок позволяют расширить возможности применения контакторов в комплексах автоматизации различных технологических систем. Изделия работают по определенному принципу. Мостик, установленный на пружинном механизме, выступает в качестве толкателя. Преимущества контактных приставок:

← Преведущая статья Вас может заинтересовать: Пускатели электромагнитные С нами можно связаться |

Аэропорт Пакатоа-Айленд (PKL) Пакатоа-Айленд Новая Зеландия

Страна: Новая Зеландия (New Zealand)

ISO код страны: NZ

Город: Пакатоа-Айленд (Pakatoa Island)

Название аэропорта: Пакатоа-Айленд (Pakatoa Island)

Код IATA: PKL

Часовой пояс: -12. 0 GMT Pacific/Auckland

0 GMT Pacific/Auckland

Высота над уровнем моря: 0 метров

Cамые дешевые авиабилеты Пакатоа-Айленд

Поиск дешёвых авиабилетов по всем авиакомпаниям

Контакты аэропорта Пакатоа-Айленд

Широта: -36.350000000000

Долгота: 174.150000000000

Онлайн табло прилёта и табло вылета аэропорта Пакатоа-Айленд (PKL).

- Прилёт

- Вылет

Расшифровка значений:

Время с окончанием AM = до полудня (пример: 6:35 AM = 06:35 утра), с окончанием PM = после полудня (пример: 6:35 PM = 18:35 вечера)

Информация о рейсах предоставлена статистическим агентством FlightStats, в соответствии с их условиями использования.

Погода в Пакатоа-Айленд

Погода в аэропорте Пакатоа-Айленд (Пакатоа-Айленд) сейчас.

Для прогноза используются градусы Цельсия. Погода предоставлена forecast.io

Отели рядом с аэропортом Пакатоа-Айленд

PKL какой аэропорт

PKL аэропорт расшифровка

Название аэропорта: Пакатоа-Айленд (Pakatoa Island). Аэропорт расположен в стране: Новая Зеландия (New Zealand). Город местонахождения аэропорта г.Пакатоа-Айленд (Pakatoa Island). IATA код аэропорта Пакатоа-Айленд: PKL. Код аэропорта ИАТА это трёхбуквенный уникальный идентификатор, присваиваемый аэропортам мира Международной ассоциацией воздушного транспорта (ИАТА).

Аэропорт расположен в стране: Новая Зеландия (New Zealand). Город местонахождения аэропорта г.Пакатоа-Айленд (Pakatoa Island). IATA код аэропорта Пакатоа-Айленд: PKL. Код аэропорта ИАТА это трёхбуквенный уникальный идентификатор, присваиваемый аэропортам мира Международной ассоциацией воздушного транспорта (ИАТА).

Географические координаты аэропорта Пакатоа-Айленд.

Широта на которой расположен аэропорт: -36.350000000000, в свою очередь долгота аэропорта соответствует: 174.150000000000. Географические координаты широты и долготы определяют положение аэропорта на земной поверхности. Чтобы полностью определить положение аэропорта в трёхмерном пространстве, необходима ещё и третья координата — высота. Высота аэропорта над уровнем моря составляет 0 метров. Аэропорт расположен в часовом поясе: -12.0 GMT. В авиабилетах на самолёт всегда указывается местное время вылета и прилёта аэропорта согласно часовым поясам.

Новости Росавиации

Режим временного ограничения полетов в российские аэропорты юга и центральной части России продлен

Отбор получателей субсидии на выполнение поисково-спасательных операций (работ) и/или участии в их обеспечении

Аэропорт Великий Устюг получил заключение о соответствии

О переводе государственных услуг в области обеспечения транспортной безопасности в электронный вид

Росавиация приняла участие в IV Северном форуме по устойчивому развитию

Новости аэропортов

Пассажиропоток аэропорта Домодедово в весенне-летний период на международном направлении вырос на 13%

Red Wings открывает новое направление для путешествий из аэропорта Домодедово

NordStar открывает новое направление для перелетов из аэропорта Домодедово

Новые рейсы на популярный курорт Красного моря из аэропорта Домодедово

Air Arabia Abu Dhabi открывает рейсы из аэропорта Домодедово

Шифрование

— Как зашифровать маринованный файл в Python?

Задавать вопрос

спросил

Изменено

1 год, 2 месяца назад

Просмотрено

2к раз

У меня есть модель мл, в которой используется векторизатор. Этот векторизатор содержит конфиденциальные данные и хранится с помощью pickle в виде файла .pkl.

Этот векторизатор содержит конфиденциальные данные и хранится с помощью pickle в виде файла .pkl.

Как зашифровать этот файл pkl, чтобы для его расшифровки требовался ключ?

Я попытался использовать приведенный ниже код для шифрования.

def encrypt_file (путь к файлу, ключ):

f = Фернет (ключ)

с открытым (путь к файлу, "rb") в качестве файла:

# прочитать все данные файла

file_data = файл.чтение()

# зашифровать данные

зашифрованные_данные = f.encrypt (данные_файла)

с открытым (путь к файлу, "wb") в качестве файла:

file.write(зашифрованные_данные)

def decrypt_file (путь к файлу, ключ):

f = Фернет (ключ)

с открытым (путь к файлу, "rb") в качестве файла:

зашифрованные_данные = файл.чтение()

расшифрованные_данные = f.decrypt(зашифрованные_данные)

вернуть расшифрованные_данные

Когда я использую функцию в текстовом файле, она работает. Проблема в том, что файл pkl, похоже, не зашифрован, так как его все еще можно использовать без расшифровки.

- python

- шифрование

- nlp

- криптография

- рассол

5

Я также не смог заставить его правильно зашифровать/расшифровать файл рассола. Он дал мне искаженные данные по расшифровке.

Итак, я сделал следующее, переключил библиотеки. pyAesCrypt делает именно то, что вам нужно, поэтому вам не нужно изобретать велосипед.

См. этот пример кода:

импортный рассол

импортировать pyAesCrypt

def create_pickle (picklefile):

данные = {"данные": "случайный"}

с open(picklefile, "wb") в качестве выходного файла:

pickle.dump(данные, внешний файл)

password = "пожалуйста, используйте длинный и случайный пароль"

picklefile = "somefile.pkl"

picklefile_enc = f"{picklefile}.aes"

jsonfile = "tmp.json"

create_pickle (рассол)

# зашифровать

pyAesCrypt.encryptFile (picklefile, picklefile_enc, пароль)

# расшифровать

pyAesCrypt.decryptFile(picklefile_enc, f"2_{picklefile}", пароль)

с open(f"2_{picklefile}", "rb") в качестве входящего файла:

печать (pickle. load (infile))

load (infile))

вывод

{'данные': 'случайный'}

Зарегистрируйтесь или войдите в систему

Зарегистрируйтесь с помощью Google

Зарегистрироваться через Facebook

Зарегистрируйтесь, используя электронную почту и пароль

Опубликовать как гость

Электронная почта

Требуется, но не отображается

Опубликовать как гость

Электронная почта

Требуется, но не отображается

parallel-wavegan · PyPI

Этот репозиторий содержит НЕОФИЦИАЛЬНЫХ параллельных реализаций WaveGAN и MelGAN с Pytorch.

Вы можете комбинировать эти современные неавторегрессионные модели, чтобы создать свой собственный великолепный вокодер!

Пожалуйста, проверьте наши образцы в нашей демонстрации HP.

Источник рисунка: https://arxiv.org/pdf/1910.11480.pdf

Целью этого репозитория является предоставление нейронного вокодера в реальном времени, совместимого с ESPnet-TTS.

Вы можете попробовать демонстрацию сквозного преобразования текста в речь в реальном времени в Google Colab!

Что нового

- 22.02.2020 (Новинка!) Доступны образцы MelGAN G + MelGAN D + STFT-loss!

- 12.02.2020 Поддержите дискриминатор MelGAN!

- 08.02.2020 Поддержите генератор MelGAN!

Требования

Этот репозиторий протестирован на Ubuntu 16.04 с графическим процессором Titan V.

- Python 3.6+

- Куда 10.0

- КуДНН 7+

- NCCL 2+ (для распределенного обучения работе с несколькими GPU)

- libsndfile (можно установить через

sudo apt установить libsndfile-devв Ubuntu) - jq (можно установить через

sudo apt install jqв ubuntu)

Другая версия cuda должна работать, но не тестироваться явно.

Все коды протестированы на Pytorch 1.0.1, 1.1, 1.2, 1.3.1 и 1.4.

Настройка

Вы можете выбрать один из двух способов установки.

A. Используйте pip

$ git clone https://github.com/kan-bayashi/ParallelWaveGAN.git

$ cd ParallelWaveGAN

$ пип установить -e .

# Если вы хотите использовать распределенное обучение, установите

# apex вручную, следуя https://github.com/NVIDIA/apex

$ ...

Обратите внимание, что ваша версия cuda должна точно совпадать с версией, используемой для двоичного файла pytorch для установки apex.

Чтобы установить pytorch, скомпилированный с другой версией cuda, см. tools/Makefile .

B. Сделать virtualenv

$ git clone https://github.com/kan-bayashi/ParallelWaveGAN.git

$ cd ParallelWaveGAN/инструменты

$ сделать

# Если вы хотите использовать распределенное обучение, запустите следующий

# команда для установки apex.

$ сделать вершину

Обратите внимание, что мы указываем версию cuda, используемую для компиляции колеса pytorch.

Если вы хотите использовать другую версию cuda, проверьте tools/Makefile , чтобы изменить устанавливаемое колесо pytorch.

Выполнить

Этот репозиторий содержит рецепты в стиле Kaldi, как и ESPnet.

В настоящее время поддерживаются пять рецептов.

- CMU Arctic: англоговорящие

- LJSpeech: женщина, говорящая по-английски

- JSUT: говорящая на японском языке женского пола

- CSMSC: женщина, говорящая на китайском языке

- JNAS: японский мультидинамик

Чтобы запустить рецепт, следуйте приведенным ниже инструкциям.

# Перейдем к каталогу рецептов

$ cd egs/ljspeech/voc1

# Запустить рецепт с нуля

$ ./run.sh

# Вы можете изменить конфигурацию через командную строку

$ ./run.sh --conf

# Вы можете выбрать этап для запуска и остановки

$ ./run.sh --этап 2 --stop_этап 2

# Если вы хотите указать GPU

$ CUDA_VISIBLE_DEVICES=1 ./run.sh --стадия 2

# Если вы хотите возобновить тренировку с контрольной точки 10000 шагов

$ . /run.sh --stage 2 --resume <путь>/<к>/checkpoint-10000steps.pkl

/run.sh --stage 2 --resume <путь>/<к>/checkpoint-10000steps.pkl

Интеграцию с планировщиками заданий, такими как slurm, можно выполнить с помощью cmd.sh и conf/slurm.conf .

Если вы хотите использовать его, пожалуйста, проверьте эту страницу.

Все гиперпараметры записываются в один файл конфигурации формата yaml.

Пожалуйста, проверьте этот пример в рецепте ljspeech.

Для обучения требуется ~3 дня с одним GPU (TITAN V).

Скорость обучения 0,5 секунды на итерацию, всего ~ 200000 сек (= 2,31 дня).

: Вы можете следить за ходом обучения через тензорную доску.

$ тензорная доска --logdir exp

Если вы хотите ускорить обучение, вы можете попробовать распределенное обучение с несколькими графическими процессорами на базе apex.

Вам необходимо установить apex для распределенного обучения. Пожалуйста, убедитесь, что вы уже установили его.

Затем вы можете запустить распределенное обучение с несколькими GPU с помощью следующей команды:

# в случае количества GPU = 8

$ CUDA_VISIBLE_DEVICES="0,1,2,3,4,5,6,7". /run.sh --стадия 2 --n_gpus 8

/run.sh --стадия 2 --n_gpus 8

В случае распределенного обучения размер пакета будет автоматически умножен на количество GPU.

Будьте осторожны.

Скорость декодирования составляет RTF = 0,016 с TITAN V, что намного быстрее, чем в реальном времени.

[расшифровка]: 100%|██████████| 250/250 [00:30<00:00, 8,31 ит/с, RTF=0,0156]

2019-11-03 09:07:40,480 (декодирование:127) ИНФОРМАЦИЯ: завершено создание 250 высказываний (RTF = 0,016).

Даже на ЦП (ЦП Intel(R) Xeon(R) Gold 6154 @ 3,00 ГГц, 16 потоков) он может генерировать меньше, чем в режиме реального времени.

[расшифровка]: 100%|██████████| 250/250 [22:16<00:00, 5,35 с/ит, RTF=0,841]

2019-11-06 09:04:56,697 (декодирование:129) ИНФОРМАЦИЯ: завершено создание 250 высказываний (RTF = 0,734).

Если вы используете генератор MelGAN, скорость декодирования будет еще выше.

# На ЦП (ЦП Intel(R) Xeon(R) Gold 6154 с тактовой частотой 3,00 ГГц, 16 потоков)

[расшифровать]: 100%|██████████| 250/250 [04:00<00:00, 1,04 ит/с, RTF=0,0882]

08. 02.2020 10:45:14,111 (декодирование:142) ИНФОРМАЦИЯ: Завершено создание 250 высказываний (RTF = 0,137).

# На графическом процессоре (TITAN V)

[расшифровать]: 100%|██████████| 250/250 [00:06<00:00, 36,38 ит/с, RTF=0,00189]

08.02.2020, 05:44:42,231 (декодирование: 142) ИНФОРМАЦИЯ: Завершено создание 250 высказываний (RTF = 0,002).

02.2020 10:45:14,111 (декодирование:142) ИНФОРМАЦИЯ: Завершено создание 250 высказываний (RTF = 0,137).

# На графическом процессоре (TITAN V)

[расшифровать]: 100%|██████████| 250/250 [00:06<00:00, 36,38 ит/с, RTF=0,00189]

08.02.2020, 05:44:42,231 (декодирование: 142) ИНФОРМАЦИЯ: Завершено создание 250 высказываний (RTF = 0,002).

Результаты

Здесь результаты сведены в таблицу.

Прослушать образцы и скачать предварительно обученные модели можно по ссылке на нашем гугл диске.

| Модель | Конф. | Ланг | Частота кадров [Гц] | Диапазон Mel [Гц] | БПФ/прыжок/выигрыш [pt] | # это |

|---|---|---|---|---|---|---|

| ljspeech_parallel_wavegan.v1 | ссылка | ЕН | 22.05к | 80-7600 | 1024/256/Нет | 400к |

ljspeech_parallel_wavegan. v1.long v1.long | ссылка | ЕН | 22.05к | 80-7600 | 1024/256/Нет | 1000к |

| ljspeech_parallel_wavegan.v1.no_limit | ссылка | ЕН | 22.05к | Нет | 1024 / 256 / Нет | 400к |

| ljspeech_melgan.v1 | ссылка | ЕН | 22.05к | 80-7600 | 1024/256/Нет | 400к |

| ljspeech_melgan.v1.long | ссылка | ЕН | 22.05к | 80-7600 | 1024/256/Нет | 1000к |

ljspeech_melgan_large. v1 v1 | ссылка | ЕН | 22.05к | 80-7600 | 1024/256/Нет | 400к |

| ljspeech_melgan_large.v1.long | ссылка | ЕН | 22.05к | 80-7600 | 1024/256/Нет | 1000к |

| ljspeech_melgan.v3 (новинка!) | ссылка | ЕН | 22.05к | 80-7600 | 1024/256/Нет | 2000к |

| ljspeech_melgan.v3.long (Новинка!) | ссылка | ЕН | 22.05к | 80-7600 | 1024/256/Нет | 4000к |

jsut_parallel_wavegan. v1 v1 | ссылка | JP | 24к | 80-7600 | 2048 / 300 / 1200 | 400к |

| csmsc_parallel_wavegan.v1 | ссылка | Ж | 24к | 80-7600 | 2048 / 300 / 1200 | 400к |

| arctic_slt_parallel_wavegan.v1 | ссылка | ЕН | 16к | 80-7600 | 1024/256/Нет | 400к |

| jnas_parallel_wavegan.v1 | ссылка | JP | 16к | 80-7600 | 1024/256/Нет | 400к |

Если вы хотите проверить больше результатов, зайдите на наш диск Google.

Как использовать предварительно обученные модели

Здесь показан минимальный код для выполнения анализа-синтеза с использованием предварительно обученной модели.

# Убедитесь, что вы установили `parallel_wavegan`

# Если нет, установите через pip

$ pip установить parallel_wavegan

# Загрузите предварительно обученные модели и поместите их в каталог `pretrain_model`

$ ls pretrain_model

checkpoint-400000steps.pkl config.yml stats.h5

# Пожалуйста, поместите аудиофайл в каталог `sample` для выполнения анализа-синтеза

$ л образец/

образец.wav

# Затем выполните извлечение признаков -> нормализация признаков -> синтез

$ параллельный вейвган-препроцесс \

--config pretrain_model/config.yml \

--rootdir образец \

--dumpdir дамп/образец/исходный

100%|████████████████████████████████████████| 1/1 [00:00<00:00, 914,19 ит/с]

[Parallel(n_jobs=16)]: использование бэкенда LokyBackend с 16 одновременными исполнителями.

[Параллельно(n_jobs=16)]: выполнено 1 из 1 | прошло: 1,2 с завершено

$ параллельная нормализация вейвгана \

--config pretrain_model/config. yml \

yml \

--rootdir дамп/образец/необработанный \

--dumpdir дамп/образец/норма \

--stats pretrain_model/stats.h5

2019-11-13 13:44:29 574 (нормализовать: 87) ИНФОРМАЦИЯ: количество файлов = 1.

100%|████████████████████████████████████████| 1/1 [00:00<00:00, 513,13 ит/с]

[Parallel(n_jobs=16)]: использование бэкенда LokyBackend с 16 одновременными исполнителями.

[Параллельно(n_jobs=16)]: выполнено 1 из 1 | прошло: 0,6 с завершено

$ параллельный вейвган-декод \

--checkpoint pretrain_model/checkpoint-400000steps.pkl \

--dumpdir дамп/образец/норма \

--outdir образец

2019-11-13 13:44:31,229 (декодировать:91) ИНФОРМАЦИЯ: количество декодируемых признаков = 1.

2019-11-13 13:44:37,074 (декод: 105) ИНФОРМАЦИЯ: загружены параметры модели из pretrain_model/checkpoint-400000steps.pkl.

[расшифровка]: 100%|███████████████████| 1/1 [00:00<00:00, 18,33 ит/с, RTF=0,0146]

2019-11-13 13:44:37,132 (декодирование:129) ИНФОРМАЦИЯ: завершено создание 1 высказывания (RTF = 0,015).

# вы можете найти сгенерированную речь в каталоге `sample`

$ л образец

образец.

Контактные приставки незаменимы при необходимости включения цепи управления с задержкой относительно периода срабатывания пускателя. Изделия удобны в обращении, обладают большим эксплуатационным ресурсом.

Контактные приставки незаменимы при необходимости включения цепи управления с задержкой относительно периода срабатывания пускателя. Изделия удобны в обращении, обладают большим эксплуатационным ресурсом. Под его воздействием изменяется положение контактных пар. Механические устройства играют роль коммутаторов, при этом не потребляют электроэнергию.

Под его воздействием изменяется положение контактных пар. Механические устройства играют роль коммутаторов, при этом не потребляют электроэнергию. load (infile))

load (infile))

/run.sh --stage 2 --resume <путь>/<к>/checkpoint-10000steps.pkl

/run.sh --stage 2 --resume <путь>/<к>/checkpoint-10000steps.pkl

/run.sh --стадия 2 --n_gpus 8

/run.sh --стадия 2 --n_gpus 8

02.2020 10:45:14,111 (декодирование:142) ИНФОРМАЦИЯ: Завершено создание 250 высказываний (RTF = 0,137).

# На графическом процессоре (TITAN V)

[расшифровать]: 100%|██████████| 250/250 [00:06<00:00, 36,38 ит/с, RTF=0,00189]

08.02.2020, 05:44:42,231 (декодирование: 142) ИНФОРМАЦИЯ: Завершено создание 250 высказываний (RTF = 0,002).

02.2020 10:45:14,111 (декодирование:142) ИНФОРМАЦИЯ: Завершено создание 250 высказываний (RTF = 0,137).

# На графическом процессоре (TITAN V)

[расшифровать]: 100%|██████████| 250/250 [00:06<00:00, 36,38 ит/с, RTF=0,00189]

08.02.2020, 05:44:42,231 (декодирование: 142) ИНФОРМАЦИЯ: Завершено создание 250 высказываний (RTF = 0,002).

yml \

yml \